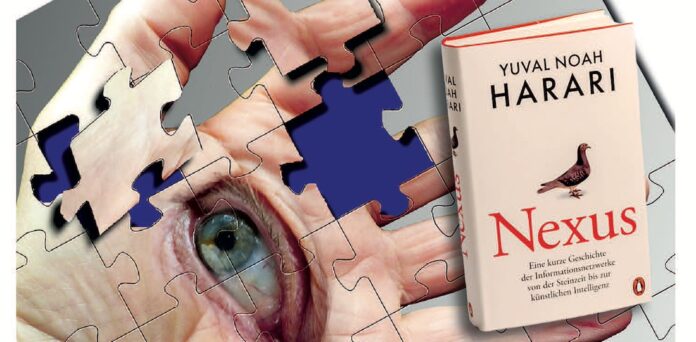

Hararis Zumutungen im „Nexus“: Informationsnetzwerke zwischen Wissen und Wahrheit

„Es gibt kein Buch mit dem Titel ‚Nexus‘ von Yuval Noah Harari“, so belehrte mich ‚meine‘ Künstliche Intelligenz, als ich mit ihr über das genannte Werk diskutieren wollte.

Doch! Das genannte Werk ist höchst real und liegt direkt vor mir. Und ist in den Weiten des Netzes auch nicht ganz spurlos verloren gegangen. Zumindest bot die KI an: „Gib mir gern mehr Kontext, und ich helfe dir weiter.“ Also tippte ich das Erscheinungsjahr 2024 des Buches ein. Das genügte – in fliegender Geschwindigkeit gab sie zu: „Entschuldige bitte die vorherige Verwirrung.“

Wenn ‚meine‘ KI menschlich gewesen wäre, hätte ich fast annehmen können, dass sie schon allein deswegen zunächst das Werk ignoriert hatte, weil es ihr Wirken in Frage stellte. Sie informierte nun: „Darin analysiert Harari, wie Informationsnetzwerke die Menschheitsgeschichte geprägt haben – von mündlichen Überlieferungen bis hin zu künstlicher Intelligenz – und welche Herausforderungen sich daraus für unsere Zukunft ergeben. Er warnt eindringlich vor den Risiken, die mit der unkontrollierten Entwicklung künstlicher Intelligenz verbunden sind. Harari fordert ein Umdenken im Umgang mit Informationen und betont die Verantwortung, die mit der Gestaltung zukünftiger Informationsstrukturen einhergeht“, so ihre Zusammenfassung.

Ja, so hatte ich es auch in seinem Buch gelesen. Doch scheint mir das Werk des israelischen Historikers aus dem vergangenen Jahr noch über eine kritische Analyse der neuen intelligenten Strukturen hinauszugehen. Er denkt aber genauso darüber nach, ob und wie Informationen zu mehr Wissen und Wahrheit führen können.

Schließlich bringen die Algorithmen sie nun schier grenzenlos und in fliegender Geschwindigkeit zu uns – schneller als vormals Brieftauben. Ist dies der Grund, warum dieser Vogel auf dem Bucheinband prangt? Seltsam starr erscheint er – eingefroren oder KI-generiert?

Seit den Tagen der Sintflut transportieren Tauben Informationen – selbst mit einem einfachen Zeichen: dem Ölzweig. Noah deutete ihn als göttliches Signal dafür, dass wieder Leben auf der Erde möglich war.

Die Deutungsebene liefern heute Algorithmen zumeist mit. Doch das geschieht nicht im luftleeren Raum. Vielmehr spiegeln sie allzu oft Muster und Vorurteile wider, die bereits in ihren Strukturen verankert sind.

Spektakulär ist das Beispiel einer KI, die Bewerbungen filterte: Sie „wusste“ aufgrund vorhandener Online-Daten, dass Frauen oder Angehörige von Minderheiten in Führungspositionen unterrepräsentiert sind. Sie interpretierte das so, dass diese daher für höhere Positionen ungeeignet seien – und sortierte sie aus. Auf diese Verknüpfung mussten Menschen erst einmal kommen!

Oft sind ihre Kriterien kaum mehr nachvollziehbar. Selbstverstärkungsmechanismen ihrer Algorithmen können dazu führen, dass sie Desinformationen und einfache Deutungsmuster bevorzugt – gerade wenn Menschen sie bevorzugt anklicken und so bestätigen. Sie ist kein absoluter „Geist“ der Wahrheit – wie etwa der Heilige Geist, der ebenfalls oft im Bild der Taube erscheint. Nein, sie gibt oft Vorurteilen oder Falschnachrichten, die im Netz ungleich stärker vorhanden sind als deren Durchbrechung, unangemessen Raum.

Erweitert Wissen Wahrheit?

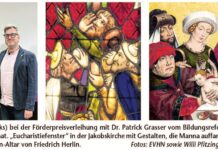

Wenn nur noch Maschinen miteinander kommunizieren, können sie „intersubjektive Wirklichkeiten“ erzeugen. Darunter versteht Harari Erzählungen, Deutungsmuster oder Glaubenssysteme, die traditionell eine Gruppe von Menschen gemeinsam teilt. Diese „Subjekte“ halten sie für real, aber sie gründet auf einer gemeinsamen Deutung eines Sachverhalts: Sicherlich wird es am Ende der Eiszeiten durch die abschmelzenden Pole Überflutungen gegeben haben – vielleicht auch besonders am Schwarzen oder am Roten Meer, wie Archäologen nun herausgefunden haben. Es wurde als „Sintflut“ gedeutet. Und gar nicht mehr danach gefragt, wo Noahs Taube so schnell nach der allgemeinen Flut einen grünen Ölzweig gefunden hat.

Stabile Ordnungsmuster

Ein zentrales Thema Hararis ist die Spannung zwischen dem Streben nach Wahrheit („die bestimmte Aspekte der Wirklichkeit korrekt darstellt“) trotz unterschiedlicher Perspektiven und übergreifender Einordnung. Das Streben nach Wahrheit kann Menschen zur Erkenntnis führen, aber es braucht Systeme, die diese Fakten einordnen. Mythen gelingt dies in ihren Bildern, die Individuen zu Kulturen, Religionen und Staaten verbinden.

Um diesen übergreifenden Gemeinwesen Stabilität zu verleihen, müssen Informationen gerade in der nun neu entdeckten schriftlichen Form so geordnet sein, dass sich auch einzelne Aufzeichnungen schnell wiederfinden lassen. Wer ist wem noch was schuldig? Wer hat bereits seine Steuern gezahlt?

Bürokratische Systeme entstehen in jedem halbwegs funktionierenden Staatswesen. Doch da sind Algorithmen schon längst schneller und strukturierter. Doch genauso können sie Einzelaspekte fehlerhaft verknüpfen und so missdeuten.

„Meine„ KI jedenfalls bestritt nicht nur zu Beginn der Recherche die reale Existenz von Hararis Buch – sondern meldete immer wieder ihre Zweifel an – so als habe sie meine „Klärung“ nicht wirklich akzeptiert.

Jedoch mit einem Beispiel aus dem Buch konnte sie mehr anfangen: Die Geschichte von „Cher Ami“, wieder einer Taube. Als ein „verlorenes Bataillon“ im Oktober 1918 von den eigenen amerikanischen Truppen irrtümlich beschossen wurde während es vom Feind eingekesselt war, brachte sie diese Nachricht ans Hauptquartier – trotz schwerer Verwundung.

Harari zeigt 20 Seiten später – gestützt auf die Forschung des Historikers Frank Blazich – dass selbst diese Erzählung mythisch überhöht ist: Neben Cher Ami waren mehreren Tauben und Funksprüche unterwegs. Die entscheidende Information war dem Hauptquartier 20 Minuten vor ihrer Ankunft bekannt. Bei der Auflösung dieser kraftvollen Erzählung bleibt die KI in meinem Gegentest ungenauer.

Gerade dieses Beispiel zeigt auch die Kraft demokratischer Selbstkorrekturmechanismen. Nur dort, wo pluralistische Gesprächsbereitschaft herrscht, können Deutungsmuster korrigiert werden. Demokratien sind nicht deshalb überlegen, weil sie Wahlen abhalten – das tun auch autoritäre Regime – sondern weil sie über Schutzmechanismen wie Gewaltenteilung, unabhängige Medien und eine lebendige Debattenkultur verfügen. Dagegen warnt Harari vor populistischen Strömungen, die behaupten, den „wahren Willen des Volkes“ zu kennen – und damit offene Debatten untergraben. In dem Balanceakt von Daten und Deutungen, Kontrolle und Freiheit liegt die Verantwortung des Menschen, reflektiert mit Information umzugehen.

Yuval Noah Harari: Nexus. Penguin-Verlag 2024, ISBN 978-3-3286-03757, 656 Seiten, 28 Euro.